No último dia 03 de dezembro, o INEP (Instituto Nacional de Estudos e Pesquisas Educacionais Anísio Teixeira), órgão ligado ao Ministério da Educação divulgou o relatório de desempenho dos alunos brasileiros que participaram da edição 2018 do Programa Internacional de Avaliação de Estudantes, o PISA.

De forma bem resumida, o PISA é um exame educacional internacional organizado pela OCDE – Organização para Cooperação e Desenvolvimento Econômico – aplicado em estudantes de escolas públicas e privadas com idades ente 15 e 16 anos de 65 países (34 deles oficialmente vinculados à OCDE). O exame é aplicado a cada dois anos e, em cada edição, há uma área de enfoque de análise (o da última edição, em 2018, o enfoque foi em leitura).

Você pode consultar mais detalhes sobre a OCDE neste link e sobre o PISA, na página do Ministério da Educação.

A (má) repercussão dos resultados foi quase instantânea. A cobertura da imprensa deu enfoque nas deficiências apresentadas por nossos estudantes, sobretudo quando comparamos alunos de países com IDH muito próximos ou em mesma modalidade (ensino público/privado) de ensino. O ministro da educação não deu qualquer indicativo de como pretende melhorar o aprendizado de nossos alunos, mas não deixou de atacar os governos antecessores e, claro, de acusar Paulo Freire de ser o verdadeiro culpado pelo analfabetismo funcional que há anos os nossos estudantes estão submetidos – mesmo sem levar em conta que quase nada da pedagogia freireana é aplicado em nossas escolas ou que Freire é um dos nomes mais citados na pesquisa educacional em todo o mundo.

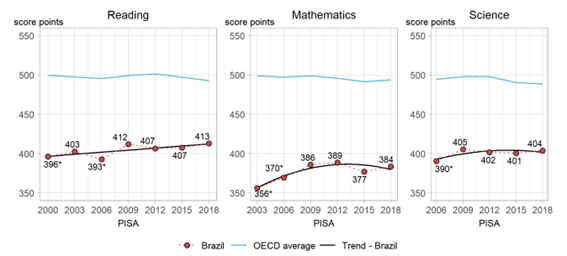

Uma breve análise nos resultados disponibilizados pelo INEP mostra que, se levarmos em conta a série histórica desde a primeira participação brasileira no PISA, mostra que os nossos alunos melhoraram o seu desempenho desde a primeira edição do exame até 2012, e desde então, mantivemos a média de aprendizagem. Ou seja, desde 2012, o desempenho de nossos alunos no PISA se manteve estável, mas ainda abaixo da média dos países da OCDE:

O Pisa avalia habilidades e competências em três áreas: leitura (reading), matemática e ciências, priorizando uma das áreas em cada edição. Nesta última, o exame priorizou a avaliação das competências de leitura. Com essa rotatividade entre as áreas – e com o uso da Teoria de Resposta ao Item, a mesma metodologia de composição e de análise das provas do Enem -, é possível ter uma visão um pouco mais ampla sobre o desempenho dos alunos e verificar se as políticas públicas em educação surtiram algum efeito.

Mas há algo que pouco é comentado pela mídia quando falamos de educação (e aqui, especificamente em educação em ciências): aprender é muito diferente de memorizar e ler bem não é garantia de aprendizado.

É muito comum comparar o aprendizado de alguém com aquilo que costumo chamar de “método da Escolinha do Professor Raimundo” para verificar o que um aluno sabe. E neste caso, o que ele sabe é medido pura e simplesmente pela sua capacidade de memorização de datas e de fatos, sem ao menos fazer um mínimo julgamento como os conceitos se interligam com o seu cotidiano e explicam fenômenos ou fatos. Esse modelo é herança de nossos primeiros modelos educacionais, em que o importante era saber o máximo de coisas, como uma enciclopédia ambulante (e as críticas a ele, vindas ate de Richard Feynman, são antigas) e se perpetuou com a cada vez mais concorrida entrada no ensino superior, sobretudo nas instituições públicas. Há quem meça a qualidade de uma escola pela quantidade de assuntos que os seus alunos aprendem, como se todos estivessem em uma corrida: na escola X, os alunos já estão no assunto A, enquanto na escola Y, os alunos já foram para o assunto B. Ou há quem critique a escola não por suas estruturas ou currículos defasados, mas por formar pessoas que não são capazes de lembrar nome dos dois afluentes do rio amazonas. A esquete a seguir, dos Trapalhões, mostra bem tudo isso:

Então o “bom” aluno de ciências é aquele que consegue memorizar o maior número de expressões matemáticas utilizadas em Física (a.k.a. fórmulas) ou que consegue misturar dois ou mais reagentes e produzir um punhado de luzes.

Mesmo com as mudanças propostas pelo Enem, em que a avaliação se dá justamente na medida em que os alunos conseguem utilizar os conceitos de todas as áreas do conhecimento para interpretar e resolver situações ou propor intervenções, ainda se concebe o ensino de ciências como uma mistura mal feita entre a memorização de conceitos e de resolução de problemas complexos que exigem, sobretudo, profundo conhecimento matemático.

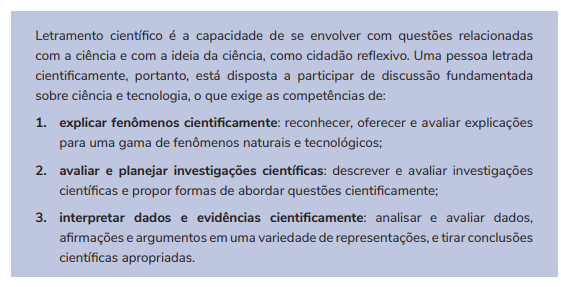

E é aqui que o Pisa (e outros exames similares, como o próprio ENEM) escancara as nossas deficiências em termos de educação: o que é avaliado não é a capacidade de memorização de conceitos ou de resolução matemática de problemas, e sim, como os alunos utilizam seus conhecimentos na explicação, avaliação e interpretação de dados e de evidências científicas:

Ensinar e aprender ciências vai muito mais além do que ser capaz de repetir leis, teorias e manipular variáveis em busca de um resultado numérico. Quando finalmente compreendermos a necessidade de se aprender ciências como mecanismo essencial para entender o mundo que nos cerca, teremos avançado muito na melhoria da qualidade de nossa educação. Afinal, saber ciências vai muito mais além do que saber recitar frases de duplo sentido.

. . . . .

O ccult.org é um projeto de divulgação científica independente sobre temas de cultura científica e ensino de ciências da natureza criado e mantido por F. C. Gonçalves desde fevereiro de 2019. Conheça o projeto.

Você pode contribuir financeitamente com o ccult.org. A partir de R$ 1 por mês, você ajuda o projeto a crescer cada vez mais, recebe brindes especiais e ainda concorre a prêmios exclusivos! Acesse: apoia.se/siteccult e saiba mais.